问题

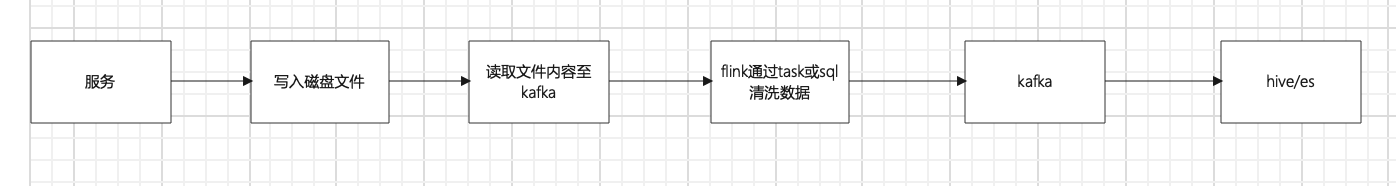

当服务qps过高时,如果收集业务日志时直接写入kafka可能会导致接口延时上升,另外直接写入的日志不一定可直接使用,需要经过fink过滤处理,固采用以下方式收集海量的业务日志

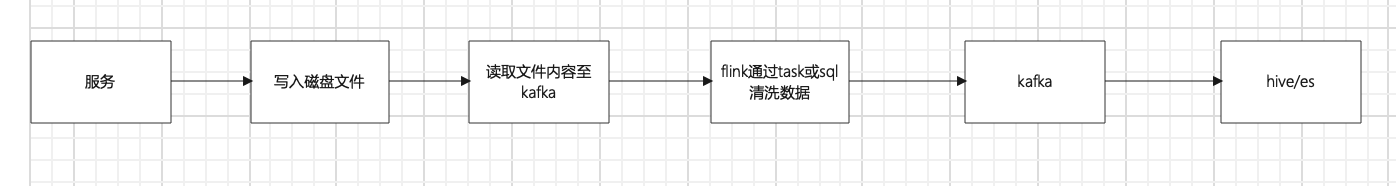

- 服务将日志通过 log的方式写入碰盘文件,可异步写,降低io次数

- 有专门的agent采集文件日志,并写入kafka

- 将kafka的数据传输至flink中进行过滤处理,然后再导入另一个kafka topic

- 读取新的kafka topic数据,写入hive或 es

当服务qps过高时,如果收集业务日志时直接写入kafka可能会导致接口延时上升,另外直接写入的日志不一定可直接使用,需要经过fink过滤处理,固采用以下方式收集海量的业务日志